Modele lingvistice mari (LLM): Ghid complet în 2023

Tot ce trebuie să știi despre LLM

Tabelul de index

- Introducere

- Ce sunt modelele lingvistice mari?

- Factori esentiali

- Exemple populare de LLM

- Elementele de bază ale LLM-urilor

- Cum sunt instruiți modelele LLM?

- LLM se bazează pe învățarea supravegheată sau nesupravegheată

- Antrenează LLM

- Ascensiunea LLM

- Cazuri de utilizare populare ale LLM

- Securitate și conformitate

- Reglarea fină a unui LLM

- FAQ

Descărcați cartea electronică

Introducere

Te-ai scărpinat vreodată în cap, uimit de modul în care Google sau Alexa păreau să te „prindă”? Sau te-ai trezit citind un eseu generat de computer care sună ciudat de uman? Nu esti singur. Este timpul să tragem cortina și să dezvăluim secretul: modele de limbaj mari sau LLM.

Ce sunt astea, te întrebi? Gândiți-vă la LLM-urile ca la vrăjitori ascunși. Ele ne alimentează chaturile digitale, ne înțeleg frazele încurcate și chiar scriu ca noi. Ne transformă viețile, făcând SF o realitate.

Acest ghid este despre toate lucrurile LLM. Vom explora ce pot face, ce nu pot face și unde sunt folosite. Vom examina modul în care ne afectează pe toți într-un limbaj simplu și simplu.

Deci, să începem călătoria noastră captivantă în LLM.

Pentru cine este acest ghid?

Acest ghid extins este pentru:

- Voi toți antreprenorii și antreprenorii solitar care strângeți o cantitate masivă de date în mod regulat

- AI și învățarea automată sau profesioniști care încep cu tehnicile de optimizare a proceselor

- Managerii de proiect care intenționează să implementeze un timp de lansare mai rapid pe piață pentru modulele lor AI sau produsele bazate pe AI

- Și pasionaților de tehnologie cărora le place să intre în detaliile straturilor implicate în procesele AI.

Ce sunt modelele lingvistice mari?

Modelele de limbaj mari (LLM) sunt sisteme avansate de inteligență artificială (AI) concepute pentru a procesa, înțelege și genera text asemănător omului. Acestea se bazează pe tehnici de învățare profundă și sunt instruite pe seturi de date masive, care conțin de obicei miliarde de cuvinte din diverse surse, cum ar fi site-uri web, cărți și articole. Această pregătire extinsă permite LLM-urilor să înțeleagă nuanțele de limbă, gramatică, context și chiar unele aspecte ale cunoștințelor generale.

Unele LLM populare, cum ar fi GPT-3 de la OpenAI, folosesc un tip de rețea neuronală numită transformator, care le permite să gestioneze sarcini de limbaj complexe cu o competență remarcabilă. Aceste modele pot îndeplini o gamă largă de sarcini, cum ar fi:

- Răspunzând la întrebări

- Rezumat text

- Traducerea limbilor

- Generarea de conținut

- Chiar și implicarea în conversații interactive cu utilizatorii

Pe măsură ce LLM-urile continuă să evolueze, ele dețin un potențial mare pentru îmbunătățirea și automatizarea diferitelor aplicații din industrii, de la servicii pentru clienți și crearea de conținut până la educație și cercetare. Cu toate acestea, ele ridică și preocupări etice și societale, cum ar fi comportamentul părtinitor sau utilizarea abuzivă, care trebuie abordate pe măsură ce tehnologia avansează.

Factori esențiali în construirea unui corpus de date LLM

Trebuie să construiți un corpus cuprinzător de date pentru a pregăti cu succes modele de limbaj. Acest proces implică colectarea de date vaste și asigurarea calității și relevanței acestora. Să ne uităm la aspectele cheie care influențează semnificativ dezvoltarea unei biblioteci de date eficiente pentru formarea modelelor lingvistice.

Prioritizează calitatea datelor alături de cantitate

Un set mare de date este fundamental pentru formarea modelelor lingvistice. Cu toate acestea, calitatea datelor are o mare importanță. Modelele instruite pe date extinse, dar slab structurate pot produce rezultate inexacte.

În schimb, seturile de date mai mici, îngrijite cu meticulozitate, conduc adesea la performanțe superioare. Această realitate arată importanța unei abordări echilibrate a colectării datelor. Datele reprezentative, diverse și relevante pentru domeniul de aplicare al modelului necesită o selecție diligentă, curățare și organizare.

Selectați Surse de date adecvate

Alegerea surselor de date ar trebui să se alinieze cu obiectivele specifice ale aplicației modelului.

- Modelele care generează dialog ar beneficia de surse precum conversațiile și interviurile sunt neprețuite.

- Modelele care se concentrează pe generarea de cod vor beneficia de depozite de cod bine documentate.

- Operele literare și scenariile oferă o mulțime de materiale de instruire pentru cei care vizează scrierea creativă.

Trebuie să includeți date care acoperă limbile și subiectele vizate. Vă ajută să personalizați modelul pentru a funcționa eficient în domeniul său desemnat.

Utilizați generarea de date sintetice

Îmbunătățirea setului de date cu date sintetice poate umple golurile și poate extinde gama. Puteți utiliza creșterea datelor, modele de generare de text și generarea bazată pe reguli pentru a crea date artificiale care să reflecte tiparele din lumea reală. Această strategie extinde diversitatea setului de instruire pentru a spori reziliența modelului și pentru a ajuta la reducerea părtinirilor.

Asigurați-vă că verificați calitatea datelor sintetice, astfel încât acestea să contribuie pozitiv la capacitatea modelului de a înțelege și de a genera limbaj în domeniul său țintă.

Implementați colectarea automată a datelor

Automatizarea procesului de colectare a datelor facilitează integrarea consecventă a datelor actuale și relevante. Această abordare eficientizează achiziția de date, crește scalabilitatea și promovează reproductibilitatea.

Puteți colecta eficient seturi de date variate utilizând instrumente de scraping web, API-uri și cadre de asimilare a datelor. Puteți ajusta aceste instrumente pentru a vă concentra pe date relevante de înaltă calitate. Ele optimizează materialul de instruire pentru model. Trebuie să monitorizați continuu aceste sisteme automatizate pentru a le menține acuratețea și integritatea etică.

Exemple populare de modele lingvistice mari

Iată câteva exemple proeminente de LLM-uri utilizate pe scară largă în diferite verticale din industrie:

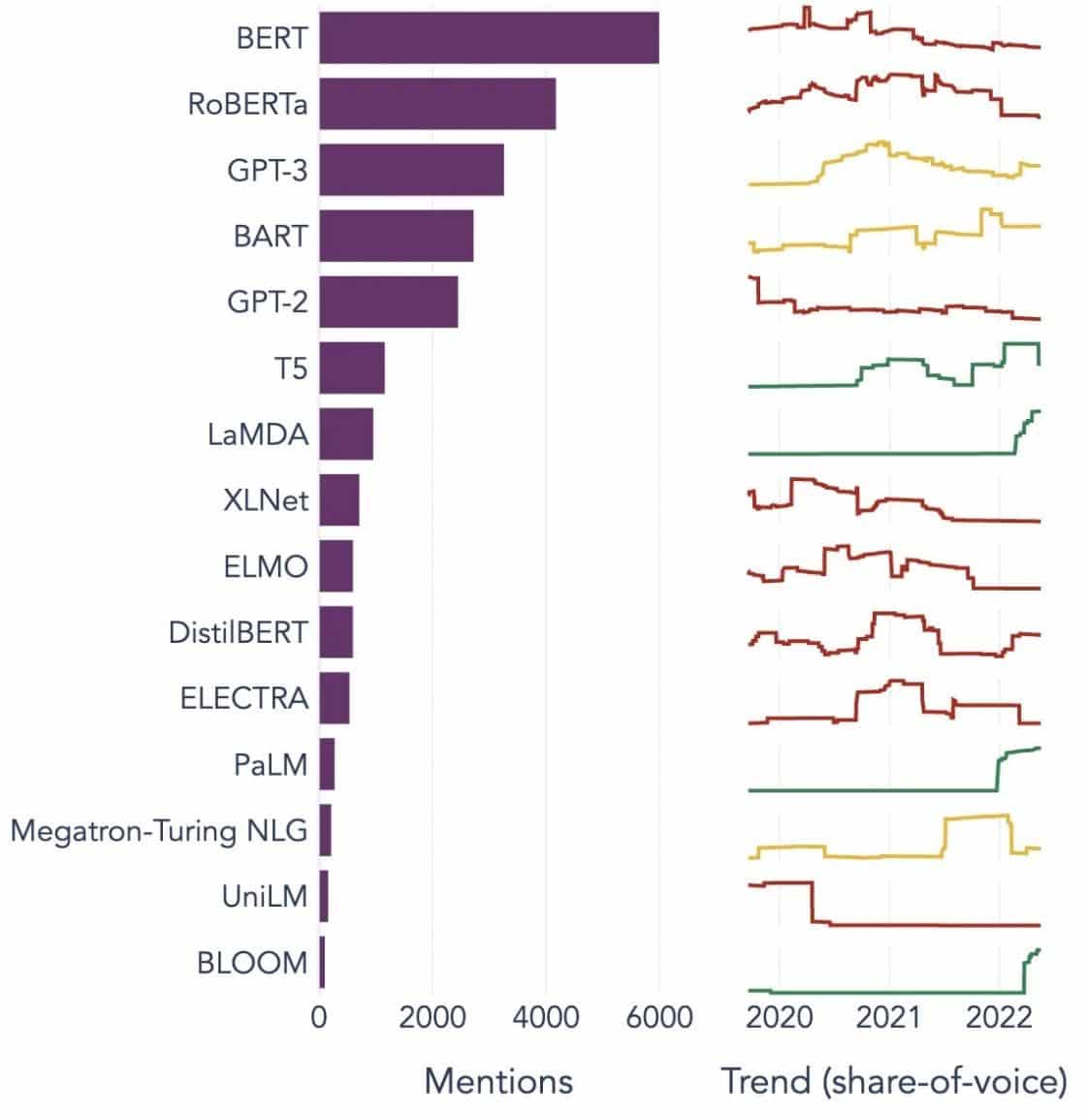

Imagine Sursa: Spre știința datelor

Înțelegerea elementelor de bază ale modelelor de limbaj mari (LLM)

Pentru a înțelege pe deplin capacitățile și funcționarea LLM-urilor, este important să ne familiarizăm cu câteva concepte cheie. Acestea includ:

Încorporarea cuvintelor

Aceasta se referă la practica de a traduce cuvinte într-un format numeric pe care modelele AI îl pot interpreta. În esență, încorporarea cuvintelor este limbajul AI. Fiecare cuvânt este reprezentat ca un vector de dimensiuni înalte care încapsulează semnificația sa semantică pe baza contextului său în datele de antrenament. Acești vectori permit inteligenței artificiale să înțeleagă relațiile și asemănările dintre cuvinte, îmbunătățind înțelegerea și performanța modelului.

Mecanisme de atenție

Aceste componente sofisticate ajută modelul AI să prioritizeze anumite elemente din textul de intrare față de altele atunci când generează o ieșire. De exemplu, într-o propoziție plină cu diverse sentimente, un mecanism de atenție ar putea acorda o greutate mai mare cuvintelor purtătoare de sentimente. Această strategie permite AI să genereze răspunsuri mai precise și mai nuanțate din punct de vedere contextual.

transformatoare

Transformatoarele reprezintă un tip avansat de arhitectură de rețea neuronală folosită pe scară largă în cercetarea LLM. Ceea ce diferențiază transformatoarele este mecanismul lor de autoatenție. Acest mecanism permite modelului să cântărească și să ia în considerare toate părțile datelor de intrare simultan, mai degrabă decât în ordine secvențială. Rezultatul este o îmbunătățire a gestionării dependențelor pe termen lung în text, o provocare comună în sarcinile de procesare a limbajului natural.

Reglaj fin

Chiar și cele mai avansate LLM-uri necesită o anumită adaptare pentru a excela în sarcini sau domenii specifice. Aici intervine reglarea fină. După ce un model este antrenat inițial pe un set de date mare, acesta poate fi rafinat în continuare sau „ajustat” pe un set de date mai mic și mai specific. Acest proces permite modelului să-și adapteze abilitățile generalizate de înțelegere a limbajului la o sarcină sau un context mai specializat.

Inginerie promptă

Solicitările de intrare servesc drept punct de plecare pentru ca LLM să genereze rezultate. Crearea eficientă a acestor prompturi, o practică cunoscută sub numele de inginerie promptă, poate influența foarte mult calitatea răspunsurilor modelului. Este un amestec de artă și știință care necesită o înțelegere aprofundată a modului în care modelul interpretează solicitările și generează răspunsuri.

Părtinire

Pe măsură ce LLM învață din datele pe care sunt instruiți, orice părtinire prezentă în aceste date poate infiltra comportamentul modelului. Acest lucru se poate manifesta ca tendințe discriminatorii sau inechitabile în rezultatele modelului. Abordarea și atenuarea acestor părtiniri reprezintă o provocare semnificativă în domeniul IA și un aspect crucial al dezvoltării de LLM-uri solide din punct de vedere etic.

interpretabilitate

Având în vedere complexitatea LLM-urilor, înțelegerea de ce iau anumite decizii sau generează rezultate specifice poate fi o provocare. Această caracteristică, cunoscută sub numele de interpretabilitate, este un domeniu cheie al cercetării în curs. Îmbunătățirea interpretabilității nu numai că ajută la depanarea și rafinarea modelului, dar și sporește încrederea și transparența în sistemele AI.

Cum sunt instruiți modelele LLM?

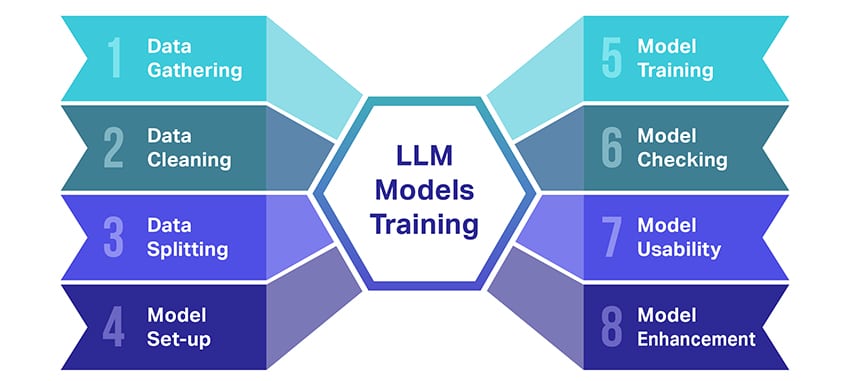

Formarea modelelor de limbaj mari (LLM) este o performanță care implică câțiva pași cruciali. Iată o prezentare simplificată, pas cu pas, a procesului:

- Colectarea datelor text: Formarea unui LLM începe cu colectarea unei cantități mari de date text. Aceste date pot proveni de la cărți, site-uri web, articole sau platforme de social media. Scopul este de a surprinde diversitatea bogată a limbajului uman.

- Curățarea datelor: Datele de text brut sunt apoi ordonate într-un proces numit preprocesare. Aceasta include sarcini precum eliminarea caracterelor nedorite, împărțirea textului în părți mai mici numite jetoane și introducerea totul într-un format cu care modelul poate funcționa.

- Împărțirea datelor: Apoi, datele curate sunt împărțite în două seturi. Un set, datele de antrenament, va fi folosit pentru a antrena modelul. Celălalt set, datele de validare, va fi folosit ulterior pentru a testa performanța modelului.

- Configurarea modelului: Structura LLM, cunoscută sub numele de arhitectură, este apoi definită. Aceasta implică selectarea tipului de rețea neuronală și decizia asupra diferiților parametri, cum ar fi numărul de straturi și unități ascunse din rețea.

- Antrenarea modelului: Acum începe antrenamentul propriu-zis. Modelul LLM învață analizând datele de antrenament, făcând predicții pe baza a ceea ce a învățat până acum și apoi ajustând parametrii interni pentru a reduce diferența dintre predicțiile sale și datele reale.

- Verificarea modelului: Învățarea modelului LLM este verificată folosind datele de validare. Acest lucru vă ajută să vedeți cât de bine funcționează modelul și să modificați setările modelului pentru o performanță mai bună.

- Utilizarea Modelului: După instruire și evaluare, modelul LLM este gata de utilizare. Acum poate fi integrat în aplicații sau sisteme în care va genera text pe baza noilor intrări pe care le-a dat.

- Îmbunătățirea modelului: În sfârșit, există întotdeauna loc de îmbunătățire. Modelul LLM poate fi rafinat și mai mult în timp, folosind date actualizate sau ajustând setările pe baza feedback-ului și a utilizării în lumea reală.

Amintiți-vă, acest proces necesită resurse de calcul semnificative, cum ar fi unități de procesare puternice și stocare mare, precum și cunoștințe specializate în învățarea automată. De aceea, de obicei este realizat de organizații de cercetare dedicate sau companii cu acces la infrastructura și expertiza necesară.

LLM se bazează pe învățarea supravegheată sau nesupravegheată?

Modelele de limbaj mari sunt de obicei antrenate folosind o metodă numită învățare supravegheată. În termeni simpli, asta înseamnă că învață din exemple care le arată răspunsurile corecte.

Așadar, dacă alimentați un LLM cu o propoziție, acesta încearcă să prezică următorul cuvânt sau frază pe baza a ceea ce a învățat din exemple. În acest fel, învață cum să genereze text care are sens și se potrivește contextului.

Acestea fiind spuse, uneori LLM-urile folosesc și un pic de învățare nesupravegheată. Este ca și cum ai lăsa copilul să exploreze o cameră plină de jucării diferite și să învețe singur despre ele. Modelul analizează datele neetichetate, modelele de învățare și structurile fără a primi răspunsurile „corecte”.

Învățarea supravegheată utilizează date care au fost etichetate cu intrări și ieșiri, spre deosebire de învățarea nesupravegheată, care nu utilizează date de ieșire etichetate.

Pe scurt, LLM-urile sunt instruite în principal folosind învățarea supravegheată, dar pot folosi și învățarea nesupravegheată pentru a-și îmbunătăți capacitățile, cum ar fi pentru analiza exploratorie și reducerea dimensionalității.

Care este volumul de date (în GB) necesar pentru formarea unui model de limbă mare?

Lumea posibilităților pentru recunoașterea datelor de vorbire și aplicațiile de voce este imensă și sunt utilizate în mai multe industrii pentru o multitudine de aplicații.

Formarea unui model de limbă mare nu este un proces unic, mai ales când vine vorba de datele necesare. Depinde de o grămadă de lucruri:

- Designul modelului.

- Ce treabă trebuie să facă?

- Tipul de date pe care le utilizați.

- Cât de bine vrei să funcționeze?

Acestea fiind spuse, formarea LLM-urilor necesită de obicei o cantitate masivă de date text. Dar despre cât de masiv vorbim? Ei bine, gândiți-vă mult dincolo de gigaocteți (GB). De obicei, ne uităm la terabytes (TB) sau chiar petabytes (PB) de date.

Luați în considerare GPT-3, unul dintre cele mai mari LLM-uri din jur. Este antrenat pe 570 GB de date text. LLM-urile mai mici ar putea avea nevoie de mai puțin – poate 10-20 GB sau chiar 1 GB de gigaocteți – dar este încă mult.

Dar nu este vorba doar de dimensiunea datelor. Calitatea conteaza si ea. Datele trebuie să fie curate și variate pentru a ajuta modelul să învețe eficient. Și nu puteți uita de alte piese cheie ale puzzle-ului, cum ar fi puterea de calcul de care aveți nevoie, algoritmii pe care îi folosiți pentru antrenament și configurația hardware pe care o aveți. Toți acești factori joacă un rol important în formarea unui LLM.

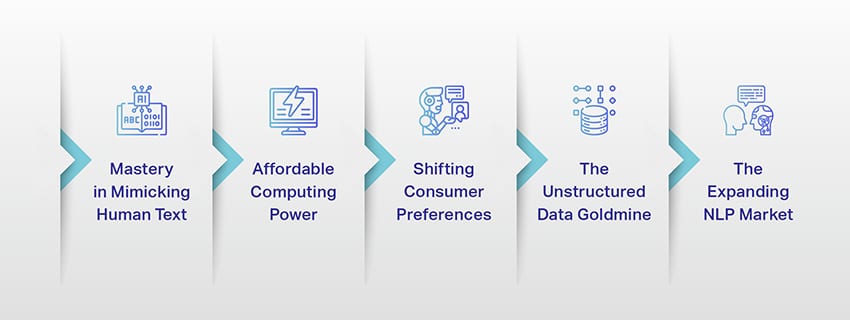

Ascensiunea modelelor lingvistice mari: de ce contează

LLM-urile nu mai sunt doar un concept sau un experiment. Aceștia joacă din ce în ce mai mult un rol esențial în peisajul nostru digital. Dar de ce se întâmplă asta? Ce face aceste LLM-uri atât de importante? Să analizăm câțiva factori cheie.

Măiestrie în imitarea textului uman

LLM-urile au transformat modul în care gestionăm sarcinile bazate pe limbaj. Construite folosind algoritmi robusti de învățare automată, aceste modele sunt echipate cu capacitatea de a înțelege nuanțele limbajului uman, inclusiv contextul, emoția și chiar sarcasmul, într-o oarecare măsură. Această capacitate de a imita limbajul uman nu este o simplă noutate, ci are implicații semnificative.

Abilitățile avansate de generare de text ale LLM-urilor pot îmbunătăți totul, de la crearea de conținut până la interacțiunile cu serviciul clienți.

Imaginați-vă că puteți pune o întrebare complexă unui asistent digital și puteți obține un răspuns care nu numai că are sens, dar este și coerent, relevant și oferit pe un ton conversațional. Aceasta este ceea ce permite LLM-urile. Acestea alimentează o interacțiune om-mașină mai intuitivă și mai captivantă, îmbogățesc experiențele utilizatorilor și democratizează accesul la informații.

Putere de calcul accesibilă

Creșterea LLM nu ar fi fost posibilă fără dezvoltări paralele în domeniul calculului. Mai precis, democratizarea resurselor de calcul a jucat un rol semnificativ în evoluția și adoptarea LLM-urilor.

Platformele bazate pe cloud oferă acces fără precedent la resurse de calcul de înaltă performanță. În acest fel, chiar și organizațiile la scară mică și cercetătorii independenți pot antrena modele sofisticate de învățare automată.

Mai mult, îmbunătățirile aduse unităților de procesare (cum ar fi GPU-urile și TPU-urile), combinate cu creșterea calculului distribuit, au făcut posibilă antrenarea modelelor cu miliarde de parametri. Această accesibilitate sporită a puterii de calcul permite creșterea și succesul LLM-urilor, conducând la mai multe inovații și aplicații în domeniu.

Schimbarea preferințelor consumatorilor

Consumatorii de astăzi nu vor doar răspunsuri; doresc interacțiuni captivante și care se pot identifica. Pe măsură ce tot mai mulți oameni cresc folosind tehnologia digitală, este evident că nevoia de tehnologie care se simte mai naturală și mai asemănătoare omului crește. LLM-urile oferă o oportunitate de neegalat de a îndeplini aceste așteptări. Prin generarea de text asemănător omului, aceste modele pot crea experiențe digitale captivante și dinamice, care pot crește satisfacția și loialitatea utilizatorilor. Fie că este vorba de chatbot AI care oferă servicii pentru clienți sau de asistenți vocali care oferă actualizări de știri, LLM-urile inaugurează o eră a AI care ne înțelege mai bine.

Mina de aur a datelor nestructurate

Datele nestructurate, cum ar fi e-mailurile, postările pe rețelele sociale și recenziile clienților, sunt o comoară de informații. Se estimează că s-a terminat 80% a datelor întreprinderii este nestructurată și crește cu o rată de 55% pe an. Aceste date sunt o mină de aur pentru companii dacă sunt utilizate în mod corespunzător.

LLM-urile intră în joc aici, cu capacitatea lor de a procesa și de a înțelege astfel de date la scară. Aceștia pot gestiona sarcini precum analiza sentimentelor, clasificarea textului, extragerea informațiilor și multe altele, oferind astfel informații valoroase.

Fie că este vorba de identificarea tendințelor din postările pe rețelele sociale sau de evaluarea sentimentului clienților din recenzii, LLM-urile ajută companiile să navigheze în cantitatea mare de date nestructurate și să ia decizii bazate pe date.

Piața NLP în expansiune

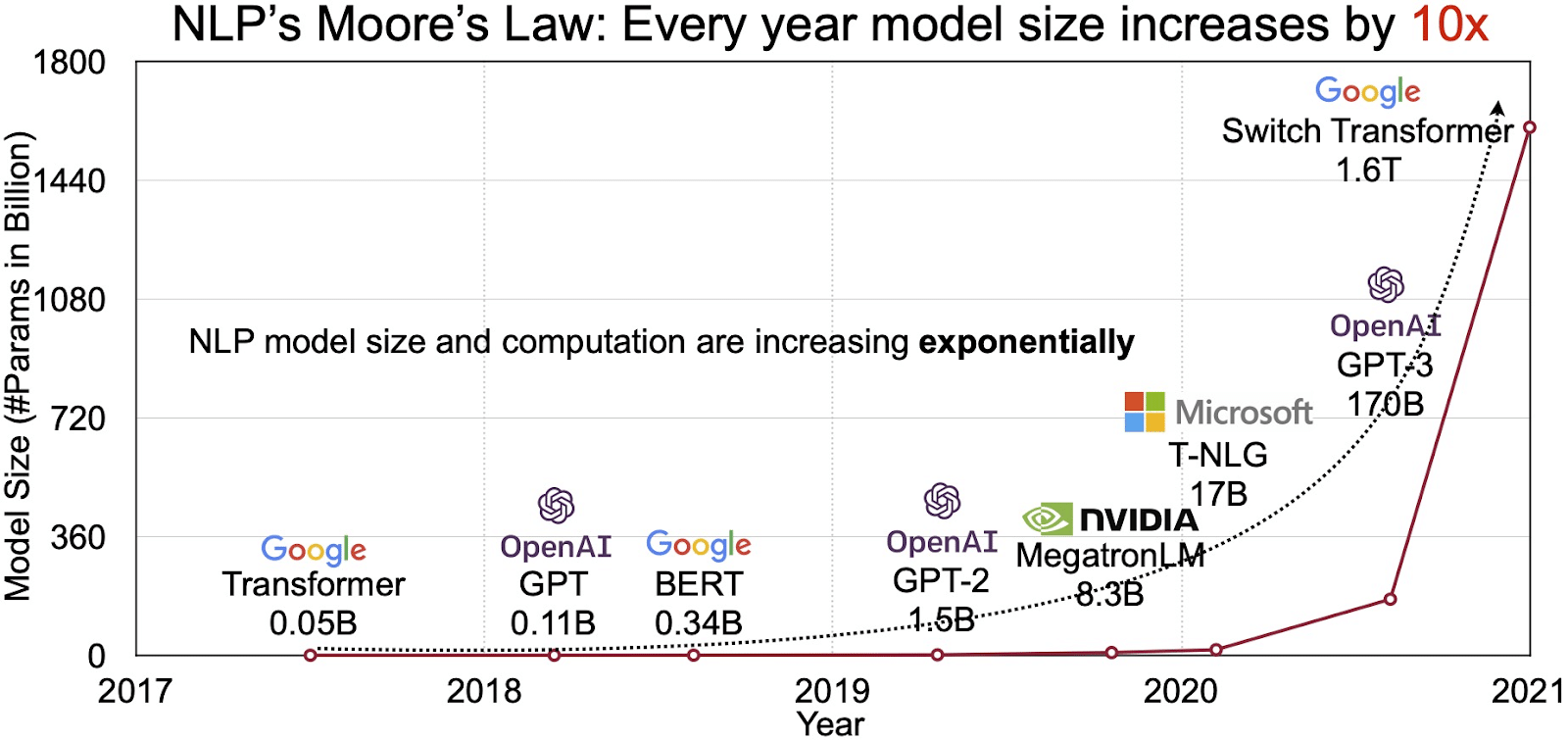

Potențialul LLM se reflectă în piața în creștere rapidă a procesării limbajului natural (NLP). Analistii proiecteaza ca piata NLP sa se extinda 11 miliarde de dolari în 2020 până la peste 35 de miliarde de dolari până în 2026. Dar nu doar dimensiunea pieței se extinde. Modelele în sine cresc și ele, atât ca dimensiune fizică, cât și ca număr de parametri pe care îi gestionează. Evoluția LLM-urilor de-a lungul anilor, așa cum se vede în figura de mai jos (sursa imaginii: link), subliniază complexitatea și capacitatea crescândă a acestora.

Cazuri de utilizare populare ale modelelor de limbaj mari

Iată câteva dintre cazurile de utilizare de top și cele mai răspândite ale LLM:

- Generarea textului în limbaj natural: Modelele de limbaj mari (LLM) combină puterea inteligenței artificiale și a lingvisticii computaționale pentru a produce în mod autonom texte în limbaj natural. Acestea pot răspunde nevoilor diverse ale utilizatorilor, cum ar fi redactarea articolelor, crearea de melodii sau implicarea în conversații cu utilizatorii.

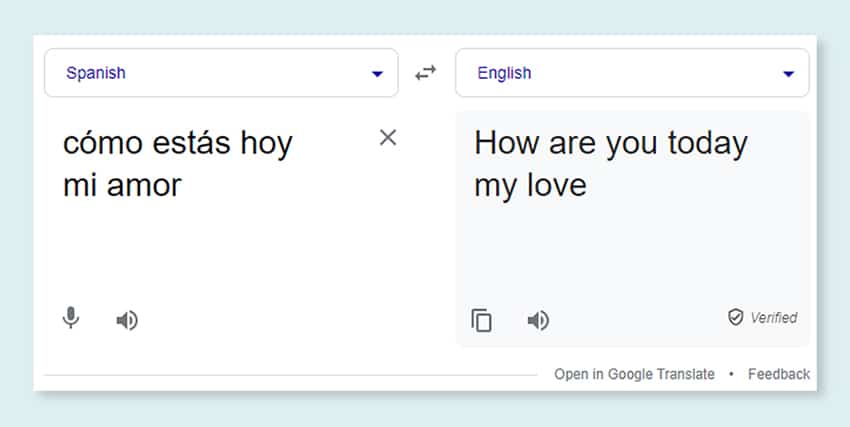

- Traducerea prin mașini: LLM-urile pot fi utilizate eficient pentru a traduce text între orice pereche de limbi. Aceste modele exploatează algoritmi de învățare profundă, cum ar fi rețelele neuronale recurente, pentru a înțelege structura lingvistică atât a limbii sursă, cât și a limbii țintă, facilitând astfel traducerea textului sursă în limba dorită.

- Crearea conținutului original: LLM-urile au deschis căi pentru ca mașinile să genereze conținut coeziv și logic. Acest conținut poate fi folosit pentru a crea postări de blog, articole și alte tipuri de conținut. Modelele profită de experiența lor profundă de învățare profundă pentru a formata și structura conținutul într-un mod nou și ușor de utilizat.

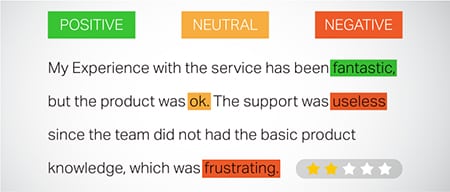

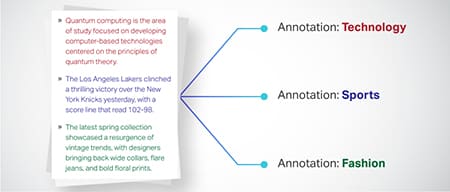

- Analiza sentimentelor: O aplicație interesantă a modelelor de limbaj mari este analiza sentimentelor. În aceasta, modelul este antrenat să recunoască și să clasifice stările emoționale și sentimentele prezente în textul adnotat. Software-ul poate identifica emoții precum pozitivitatea, negativitatea, neutralitatea și alte sentimente complicate. Acest lucru poate oferi informații valoroase asupra feedback-ului clienților și opiniilor despre diverse produse și servicii.

- Înțelegerea, rezumarea și clasificarea textului: LLM-urile stabilesc o structură viabilă pentru software-ul AI pentru a interpreta textul și contextul acestuia. Instruind modelului să înțeleagă și să examineze cantități mari de date, LLM-urile permit modelelor AI să înțeleagă, să rezume și chiar să clasifice textul în diverse forme și modele.

- Răspunzând la întrebări: Modelele de limbaj mari echipează sistemele de răspuns la întrebări (QA) cu capacitatea de a percepe și de a răspunde cu acuratețe la interogarea în limbaj natural a unui utilizator. Exemple populare ale acestui caz de utilizare includ ChatGPT și BERT, care examinează contextul unei interogări și parcurg o colecție vastă de texte pentru a oferi răspunsuri relevante la întrebările utilizatorilor.

Integrarea securității și a conformității în strategiile de date LLM

Încorporarea unor măsuri solide de securitate și conformitate în cadrul cadrelor de colectare și procesare a datelor LLM vă poate ajuta să asigurați utilizarea transparentă, sigură și etică a datelor. Această abordare cuprinde mai multe acțiuni cheie:

- Implementați criptare robustă: Protejează datele în repaus și în tranzit folosind metode puternice de criptare. Acest pas protejează informațiile de accesul neautorizat și de încălcări.

- Stabiliți controale de acces și autentificare: configurați sisteme pentru a verifica identitățile utilizatorilor și a restricționa accesul la date. Se va asigura că numai personalul autorizat poate interacționa cu informațiile sensibile.

- Integrarea sistemelor de înregistrare și monitorizare: Implementați sisteme pentru a urmări utilizarea datelor și pentru a identifica potențialele amenințări de securitate. Această monitorizare proactivă ajută la menținerea integrității și siguranței ecosistemului de date.

- Respectați standardele de conformitate: Urmați reglementările relevante, cum ar fi GDPR, HIPAA și PCI DSS, care guvernează securitatea și confidențialitatea datelor. Auditurile și verificările regulate verifică conformitatea, asigurându-se că practicile respectă standardele legale și etice specifice industriei.

- Stabiliți orientări de utilizare etică a datelor: Dezvoltați și aplicați politici care dictează utilizarea corectă, transparentă și responsabilă a datelor. Aceste orientări ajută la menținerea încrederii părților interesate și susțin un mediu de formare sigur pentru LLM.

Aceste acțiuni întăresc colectiv practicile de gestionare a datelor pentru formarea LLM. Construiește o bază de încredere și securitate care aduce beneficii tuturor părților interesate implicate.

Reglarea fină a unui model de limbă mare

Reglarea fină a unui model de limbaj mare implică un proces meticulos de adnotare. Shaip, cu expertiza sa în acest domeniu, poate ajuta în mod semnificativ acest demers. Iată câteva metode de adnotare folosite pentru a antrena modele precum ChatGPT:

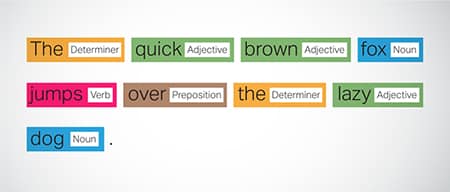

Etichetarea părții de vorbire (POS).

Cuvintele din propoziții sunt etichetate cu funcția lor gramaticală, cum ar fi verbe, substantive, adjective etc. Acest proces ajută modelul să înțeleagă gramatica și legăturile dintre cuvinte.

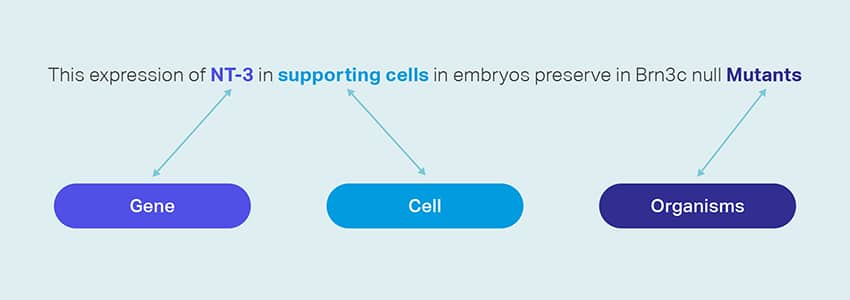

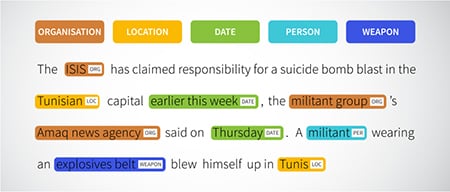

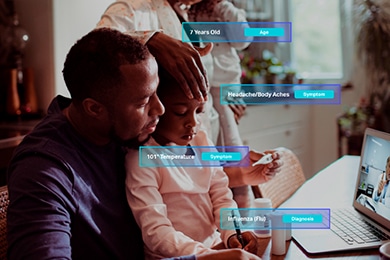

Recunoașterea entității denumite (NER)

Sunt marcate entitățile numite, cum ar fi organizațiile, locațiile și persoanele dintr-o propoziție. Acest exercițiu ajută modelul în interpretarea semnificațiilor semantice ale cuvintelor și frazelor și oferă răspunsuri mai precise.

Analiza sentimentelor

Datelor text li se atribuie etichete de sentiment precum pozitive, neutre sau negative, ajutând modelul să înțeleagă nuanța emoțională a propozițiilor. Este deosebit de util în răspunsul la întrebările care implică emoții și opinii.

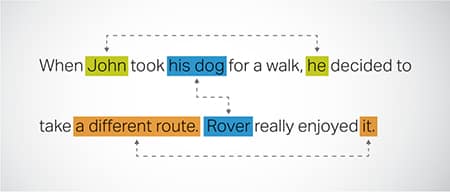

Rezoluția coreferenței

Identificarea și rezolvarea cazurilor în care se face referire la aceeași entitate în diferite părți ale unui text. Acest pas ajută modelul să înțeleagă contextul propoziției, conducând astfel la răspunsuri coerente.

Clasificarea textului

Datele text sunt clasificate în grupuri predefinite, cum ar fi recenzii despre produse sau articole de știri. Acest lucru ajută modelul să discerne genul sau subiectul textului, generând răspunsuri mai pertinente.

Shaip poate aduna date de instruire prin accesarea cu crawlere pe web din diverse sectoare precum bancar, asigurări, comerț cu amănuntul și telecomunicații. Putem oferi adnotare text (NER, analiză a sentimentelor etc.), să facilităm LLM (traducere) în mai multe limbi și să asistăm la crearea taxonomiei, extragerea/ingineria promptă.

Shaip are un depozit extins de seturi de date disponibile. Catalogul nostru de date medicale se mândrește cu o colecție largă de date de-identificate, sigure și de calitate, potrivite pentru inițiativele AI, modelele de învățare automată și procesarea limbajului natural.

În mod similar, catalogul nostru de date despre vorbire este un tezaur de date de înaltă calitate, perfect pentru produsele de recunoaștere a vocii, permițând antrenamentul eficient al modelelor AI/ML. Avem, de asemenea, un catalog impresionant de date de viziune computerizată cu o gamă largă de date de imagine și video pentru diverse aplicații.

Oferim chiar și seturi de date deschise într-o formă modificabilă și convenabilă, gratuit, pentru a fi utilizate în proiectele dvs. AI și ML. Această vastă bibliotecă de date AI vă permite să vă dezvoltați modelele AI și ML mai eficient și mai precis.

Procesul de colectare și adnotare a datelor Shaip

Când vine vorba de colectarea și adnotarea datelor, Shaip urmează un flux de lucru simplificat. Iată cum arată procesul de colectare a datelor:

Identificarea site-urilor sursă

Inițial, site-urile web sunt identificate folosind surse selectate și cuvinte cheie relevante pentru datele necesare.

Răzuire web

Odată ce site-urile web relevante sunt identificate, Shaip utilizează instrumentul său proprietar pentru a extrage datele de pe aceste site-uri.

Preprocesarea textului

Datele colectate sunt supuse procesării inițiale, care include împărțirea și analizarea propozițiilor, făcându-le potrivite pentru pașii următori.

adnotare

Datele preprocesate sunt adnotate pentru Extragerea entității denumite. Acest proces implică identificarea și etichetarea elementelor importante din text, cum ar fi numele de persoane, organizații, locații etc.

Extragerea relațiilor

În etapa finală, tipurile de relații dintre entitățile identificate sunt determinate și adnotate corespunzător. Acest lucru ajută la înțelegerea conexiunilor semantice dintre diferitele componente ale textului.

Oferta lui Shaip

Shaip oferă o gamă largă de servicii pentru a ajuta organizațiile să gestioneze, să analizeze și să profite la maximum de datele lor.

Data Web-Scraping

Un serviciu cheie oferit de Shaip este data scraping. Aceasta implică extragerea datelor din adrese URL specifice domeniului. Folosind instrumente și tehnici automate, Shaip poate colecta rapid și eficient volume mari de date de pe diverse site-uri web, manuale de produse, documentație tehnică, forumuri online, recenzii online, date despre serviciul clienți, documente de reglementare a industriei etc. Acest proces poate fi de neprețuit pentru companii atunci când culegând date relevante și specifice dintr-o multitudine de surse.

Traducere automată

Dezvoltați modele folosind seturi extinse de date multilingve asociate cu transcripții corespunzătoare pentru traducerea textului în diferite limbi. Acest proces ajută la demontarea obstacolelor lingvistice și promovează accesibilitatea informațiilor.

Extragerea și crearea taxonomiei

Shaip poate ajuta la extragerea și crearea taxonomiei. Aceasta implică clasificarea și clasificarea datelor într-un format structurat care reflectă relațiile dintre diferitele puncte de date. Acest lucru poate fi deosebit de util pentru companii în organizarea datelor, făcându-le mai accesibile și mai ușor de analizat. De exemplu, într-o afacere de comerț electronic, datele despre produse pot fi clasificate în funcție de tipul produsului, marcă, preț etc., facilitând navigarea clienților în catalogul de produse.

Colectare de date

Serviciile noastre de colectare a datelor oferă date critice din lumea reală sau sintetice, necesare pentru antrenarea algoritmilor generativi de inteligență artificială și pentru îmbunătățirea acurateței și eficacității modelelor dvs. Datele sunt imparțial, obținute din punct de vedere etic și responsabil, ținând cont de confidențialitatea și securitatea datelor.

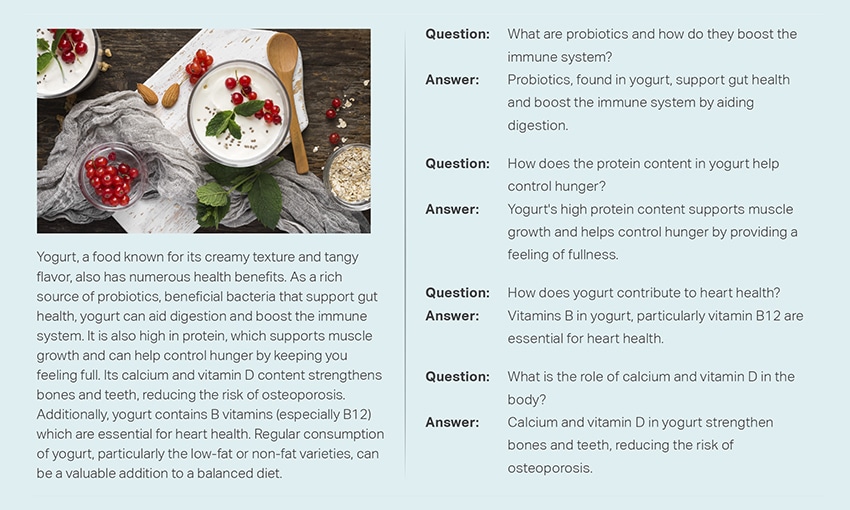

Întrebări și răspunsuri

Răspunsul la întrebări (QA) este un subdomeniu al procesării limbajului natural axat pe răspunsul automat la întrebări în limbajul uman. Sistemele de asigurare a calității sunt instruite pe text și cod extins, permițându-le să gestioneze diferite tipuri de întrebări, inclusiv cele de fapt, definiționale și bazate pe opinii. Cunoștințele domeniului sunt esențiale pentru dezvoltarea modelelor QA adaptate unor domenii specifice, cum ar fi asistența pentru clienți, asistența medicală sau lanțul de aprovizionare. Cu toate acestea, abordările generative QA permit modelelor să genereze text fără cunoștințe de domeniu, bazându-se exclusiv pe context.

Echipa noastră de specialiști poate studia meticulos documente sau manuale cuprinzătoare pentru a genera perechi Întrebare-Răspuns, facilitând crearea de IA generativă pentru afaceri. Această abordare poate aborda în mod eficient întrebările utilizatorilor prin extragerea de informații relevante dintr-un corpus extins. Experții noștri certificați asigură producerea de perechi de întrebări și răspunsuri de cea mai bună calitate, care se întind pe diverse subiecte și domenii.

Rezumarea textului

Specialiștii noștri sunt capabili să distileze conversații cuprinzătoare sau dialoguri lungi, oferind rezumate succinte și perspicace din date text extinse.

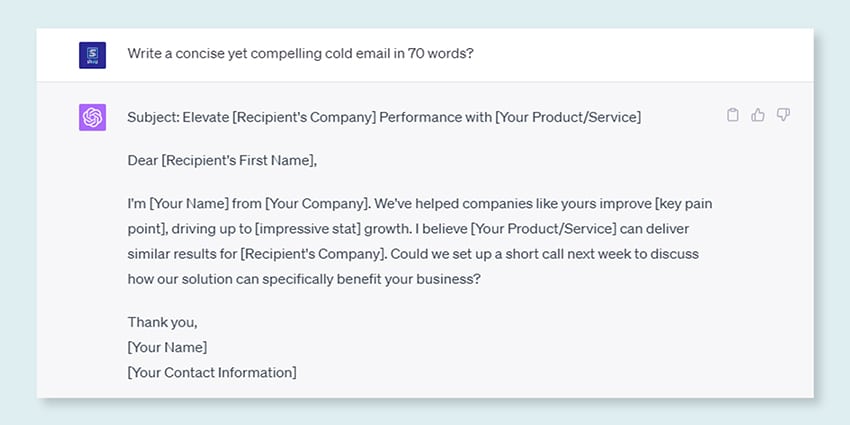

Generarea textului

Antrenați modele folosind un set larg de date de text în diverse stiluri, cum ar fi articole de știri, ficțiune și poezie. Aceste modele pot genera apoi diferite tipuri de conținut, inclusiv articole de știri, intrări pe blog sau postări pe rețelele sociale, oferind o soluție rentabilă și care economisește timp pentru crearea de conținut.

Recunoaștere a vorbirii

Dezvoltați modele capabile să înțeleagă limbajul vorbit pentru diverse aplicații. Acestea includ asistenți activați prin voce, software de dictare și instrumente de traducere în timp real. Procesul implică utilizarea unui set cuprinzător de date compus din înregistrări audio ale limbajului vorbit, asociate cu transcrierile lor corespunzătoare.

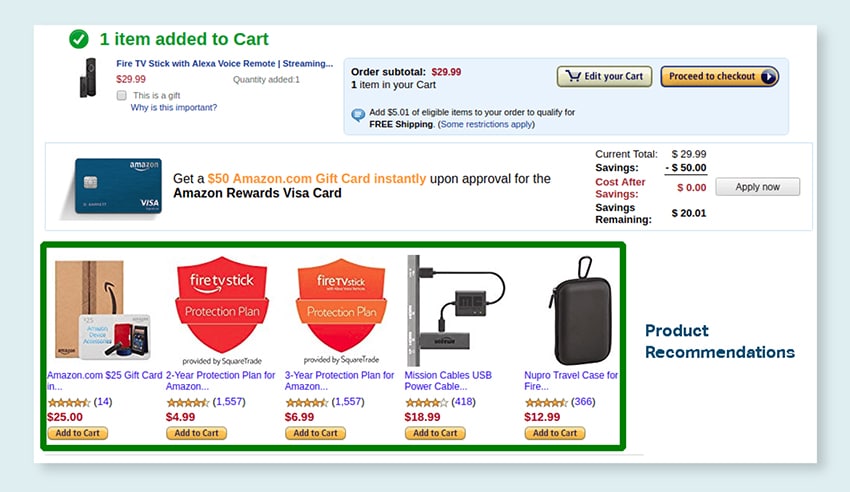

Recomandări de produs

Dezvoltați modele folosind seturi de date extinse ale istoricului de cumpărare a clienților, inclusiv etichete care indică produsele pe care clienții sunt înclinați să le cumpere. Scopul este de a oferi sugestii precise clienților, crescând astfel vânzările și sporind satisfacția clienților.

Subtitrărea imaginii

Revoluționați-vă procesul de interpretare a imaginilor cu serviciul nostru de ultimă generație, bazat pe AI. Infuzăm vitalitate imaginilor producând descrieri precise și semnificative din punct de vedere contextual. Acest lucru deschide calea pentru posibilități inovatoare de implicare și interacțiune cu conținutul dvs. vizual pentru publicul dvs.

Servicii de instruire Text-to-Speech

Oferim un set extins de date compus din înregistrări audio ale vorbirii umane, ideale pentru antrenarea modelelor AI. Aceste modele sunt capabile să genereze voci naturale și captivante pentru aplicațiile dvs., oferind astfel o experiență sonoră distinctivă și captivantă pentru utilizatorii dvs.

Catalogul nostru divers de date este conceput pentru a satisface numeroase cazuri de utilizare generative AI

Catalog de date medicale standard și licențiere:

- 5M+ Înregistrări și fișiere audio pentru medic în 31 de specialități

- 2M+ Imagini medicale în radiologie și alte specialități (RMN, CT, USG, XR)

- Peste 30 de documente cu text clinic cu entități cu valoare adăugată și adnotări de relații

Catalog de date despre vorbire de la raft și licențiere:

- Peste 40 de ore de date de vorbire (50+ limbi/100+ dialecte)

- Peste 55 de subiecte abordate

- Frecvența de eșantionare – 8/16/44/48 kHz

- Tip audio -Spontan, scenariu, monolog, cuvinte de trezire

- Seturi de date audio complet transcrise în mai multe limbi pentru conversații om-uman, robot uman, conversație în call center-ul agent uman, monologuri, discursuri, podcasturi etc.

Catalog de date de imagini și video și licențiere:

- Mâncare/Colectie de imagini de document

- Colecție video de securitate la domiciliu

- Colecție de imagini/video faciale

- Facturi, PO, Chitanțe Colectare documente pentru OCR

- Colecție de imagini pentru detectarea daunelor vehiculelor

- Colecția de imagini a plăcuțelor de înmatriculare a vehiculului

- Colecția de imagini interioare auto

- Colecție de imagini cu șoferul auto în centrul atenției

- Colecție de imagini legate de modă

Hai să vorbim

Întrebări frecvente (FAQ)

DL este un subdomeniu al ML care utilizează rețele neuronale artificiale cu mai multe straturi pentru a învăța modele complexe în date. ML este un subset de AI care se concentrează pe algoritmi și modele care permit mașinilor să învețe din date. Modelele de limbaj mari (LLM) sunt un subset al învățării profunde și împărtășesc un teren comun cu IA generativă, deoarece ambele sunt componente ale domeniului mai larg al învățării profunde.

Modelele lingvistice mari sau LLM-urile sunt modele lingvistice expansive și versatile care sunt inițial pregătite în prealabil pe date de text extinse pentru a înțelege aspectele fundamentale ale limbajului. Acestea sunt apoi reglate fin pentru aplicații sau sarcini specifice, permițându-le să fie adaptate și optimizate pentru anumite scopuri.

În primul rând, modelele de limbaj mari au capacitatea de a gestiona o gamă largă de sarcini datorită pregătirii lor extinse cu cantități masive de date și miliarde de parametri.

În al doilea rând, aceste modele prezintă adaptabilitate, deoarece pot fi reglate fin cu date minime specifice de antrenament pe teren.

În cele din urmă, performanța LLM-urilor arată o îmbunătățire continuă atunci când sunt încorporate date și parametri suplimentari, sporind eficiența acestora în timp.

Proiectarea promptului implică crearea unui prompt adaptat sarcinii specifice, cum ar fi specificarea limbii de ieșire dorite într-o sarcină de traducere. Ingineria promptă, pe de altă parte, se concentrează pe optimizarea performanței prin încorporarea cunoștințelor de domeniu, oferind exemple de rezultate sau folosind cuvinte cheie eficiente. Proiectarea promptă este un concept general, în timp ce ingineria promptă este o abordare specializată. În timp ce proiectarea promptă este esențială pentru toate sistemele, ingineria promptă devine crucială pentru sistemele care necesită precizie sau performanță ridicată.

Există trei tipuri de modele mari de limbaj. Fiecare tip necesită o abordare diferită a promovării.

- Modelele de limbaj generice prezic următorul cuvânt pe baza limbii din datele de antrenament.

- Modelele reglate cu instrucțiuni sunt antrenate pentru a prezice răspunsul la instrucțiunile date în intrare.

- Modelele reglate pentru dialog sunt antrenate să aibă o conversație de tip dialog prin generarea următorului răspuns.