În domeniul în plină dezvoltare al inteligenței artificiale (AI), accentul pe considerentele etice și corectitudine este mai mult decât un imperativ moral - este o necesitate fundamentală pentru longevitatea și acceptarea socială a tehnologiei. IA etică, sau IA echitabilă, se referă la asigurarea faptului că sistemele AI funcționează fără părtinire, discriminare sau rezultate nedrepte. Acest blog explorează importanța inteligenței artificiale etice și analizează diferitele tipuri de părtiniri de evitat.

De ce contează IA etică

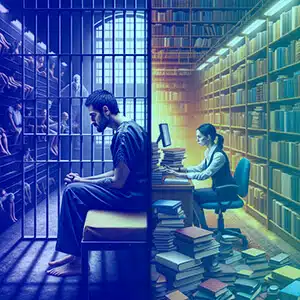

Sistemele AI devin din ce în ce mai mult parte din viața noastră de zi cu zi, luând decizii care afectează totul, de la cererile de angajare până la condamnarea judiciară. Atunci când aceste sisteme sunt părtinitoare, ele pot perpetua și amplifica inegalitățile societale, provocând prejudicii indivizilor și grupurilor. IA etică își propune să prevină astfel de rezultate prin promovarea echității, a răspunderii, a transparenței și a respectului pentru drepturile omului.

Tipuri de părtiniri și exemple

Prejudecată împotriva violenței

Sistemele AI trebuie instruite să recunoască și să omite conținutul violent. De exemplu, un model de limbaj antrenat pe text violent ar putea genera conținut dăunător, promovând agresivitatea în loc de dialog constructiv.

Subiecte controversate

Antrenarea AI pe subiecte controversate fără o moderare atentă poate duce la adoptarea AI-ului de poziții polarizate. De exemplu, o IA instruită pe date despre drepturile asupra armelor ar putea genera argumente controversate și unilaterale.

Discriminare de gen

Un exemplu clasic de prejudecată de gen este atunci când un model lingvistic asociază asistentele cu femeile și inginerii cu bărbatul, întărind stereotipurile învechite, mai degrabă decât reflectând diversitatea acestor profesii.

Prejudecăți rasiale și etnice

Luați în considerare o inteligență artificială care generează imagini ale directorilor executivi, dar care îi prezintă predominant ca aparținând unui singur grup rasial, ignorând astfel realitatea diversității în lumea corporativă.

Prejudecăți socioeconomice

Sistemele de inteligență artificială pot favoriza limbajul sau conceptele asociate cu un statut socioeconomic mai înalt, cum ar fi presupunerea că mărcile de lux sunt standardul de calitate, trecând cu vederea spectrul mai larg de experiențe ale consumatorilor.

Bias de vârstă

AI ar putea presupune în mod incorect că referințele la tehnologie nu sunt relevante pentru adulții în vârstă, excluzându-i astfel din conversațiile despre progresele digitale.

Prejudecată culturală

Un sistem de inteligență artificială ar putea genera recenzii la restaurante care se concentrează pe bucătăriile occidentale, ignorând bogăția altor tradiții culinare și, astfel, marginalizează culturile non-occidentale.

Prejudecata politică

O IA programată să organizeze articole de știri ar putea selecta în mod disproporționat articolele din partea stângă sau din dreapta spectrului politic, mai degrabă decât să prezinte o viziune echilibrată.

Prejudecată religioasă

Dacă un sistem de inteligență artificială face referire disproporționată la o religie într-o lumină pozitivă, ignorând sau denaturând altele, el prezintă părtiniri religioase.

Prejudecăți regionale

Un model de limbă poate genera rapoarte de trafic care sunt relevante doar pentru zonele urbane, cu vedere la regiunile rurale sau mai puțin populate.

Prejudecăți pentru dizabilități

Luați în considerare un consilier de sănătate AI care nu oferă opțiuni de exerciții accesibile persoanelor cu dizabilități, oferind astfel sfaturi incomplete și excluse.

Prejudecățile lingvistice

O IA de traducere poate oferi în mod constant traduceri de înaltă calitate pentru unele limbi, dar mai puțin egale pentru limbile mai puțin reprezentate în datele sale de instruire.

Bias de confirmare

O inteligență artificială ar putea amplifica credința unui utilizator într-un remediu fals prin referirea selectivă a surselor care susțin acel remediu și ignorând consensul științific.

Prejudecată contextuală

O IA ar putea interpreta cererile de informații despre „închisori” ca o anchetă penală, mai degrabă decât una academică sau juridică, în funcție de contextul în care a fost instruit.

Prejudiciul sursei de date

Dacă datele de instruire ale unui AI provin de la un forum care discută în mod predominant realizările unui anumit grup demografic, poate neglija contribuțiile altor grupuri.

Cum să evitați aceste părtiniri

Evitarea acestor părtiniri necesită o abordare cu mai multe fațete:

- Seturi diverse de date: Încorporați o gamă largă de surse de date pentru a echilibra reprezentarea în diferite grupuri.

- Audit regulat: Efectuați verificări continue pentru a identifica și corecta părtinirile.

- Transparență: Precizați modul în care sistemele AI iau decizii și despre ce date sunt instruite.

- Incluziune în echipele AI: Echipele diverse pot identifica mai bine posibilele părtiniri care ar putea fi trecute cu vederea.

- Training pentru etica: Educați dezvoltatorii AI cu privire la importanța considerațiilor etice.

- Feedback părților interesate: Implicați utilizatorii și comunitățile afectate în procesul de dezvoltare a AI.

De ce Shaip

Shaip, ca lider în soluții de date AI, oferă servicii cuprinzătoare concepute pentru a aborda direct prejudecățile AI. Prin furnizarea de seturi de date diverse și echilibrate pentru antrenarea modelelor AI, Shaip se asigură că sistemele dumneavoastră AI sunt expuse la un spectru larg de experiențe umane și demografii, reducând riscul de părtinire pe toate fronturile – de la gen și rasă la limbă și dizabilități. Procesele lor riguroase de conservare și adnotare a datelor, cuplate cu un cadru AI etic, pot ajuta organizațiile să identifice, să atenueze și să prevină încorporarea părtinirilor în sistemele AI. Experiența lui Shaip în dezvoltarea modelelor la comandă înseamnă, de asemenea, că acestea pot ajuta la crearea unei IA care este cât mai incluzivă, echitabilă și imparțială posibil, aliniată cu standardele globale ale IA etică.

Concluzie

Inteligența artificială etică este crucială pentru crearea unui viitor în care tehnologia să servească omenirea fără prejudecăți. Înțelegând și atenuând părtinirile, dezvoltatorii și părțile interesate se pot asigura că sistemele AI sunt corecte și echitabile. Responsabilitatea revine tuturor celor implicați în ciclul de viață AI de a promova un mediu în care tehnologia reflectă cele mai înalte standarde etice ale noastre, promovând o societate justă și incluzivă. Prin vigilență și dedicare față de aceste principii, AI își poate atinge adevăratul potențial ca forță spre bine.